23/07/2009

Arrefecimento global

O Grande Líder, movido pela inesgotável boa energia do ministro dos cornos, vai conseguir «safar» o planeta. O preço a pagar por tão nobre missão é a islandização de Portugal. Dito de outra forma - Portugal vai congelar e «safa-se» quem tiver o mapa dos géiseres.

22/07/2009

19/07/2009

As minhas escolhas

| Pelas Linhas da Nostalgia Para quem gosta de caminhar, resta-nos o consolo de trilhar alguns percursos de elevado valor patrimonial e paisagístico. Por enquanto. |

15/07/2009

O modelo Dinamarquês

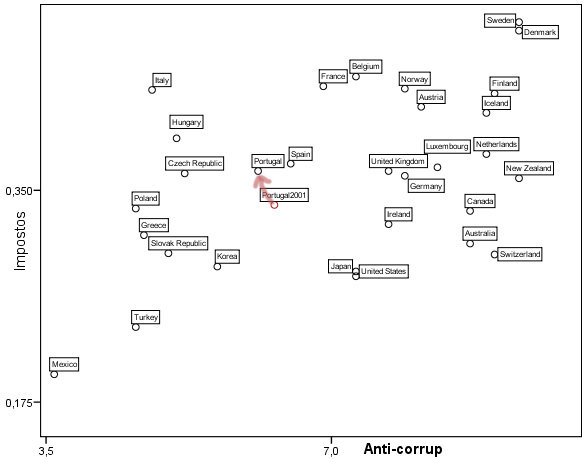

Este post de Sérgio Deusdado suscitou-me a curiosidade de consultar as estatísticas relativas ao peso da receita fiscal na economia. O gráfico abaixo apresenta, no eixo vertical, os valores dessa variável nos países da OCDE, em 2007. Para ver a dinâmica recente, representa-se também o valor de Portugal em 2001. O gráfico confirma a percepção comum: o peso dos impostos em Portugal tem aumentado. Usando uma expressão bem cara a Rui Tavares, dir-se-ia que o agravamento da fiscalidade foi uma das "políticas que nos trouxe a esta crise". Eu não diria tanto, mas digo que o aumento da fiscalidade não nos dotou de ferramentas para sair da crise "por cima".

Ouvido hoje na Comissão de Orçamento e Finanças, o Governador do Banco de Portugal disse que a «consolidação estrutural» das finanças públicas tanto pode ocorrer com elevada fiscalidade (deu o exemplo da Dinamarca) como com uma fiscalidade mais reduzida (deu o exemplo da Irlanda). Foi esta prelecção do sr. Governador ao deputado Frasquilho que me sugeriu a inclusão no gráfico de outra variável, para demonstrar que o "modelo dinamarquês", mesmo sem TGV, só funciona num determinado contexto cultural que não abrange os países latinos nem as antigas "repúblicas democráticas". Essa variável, corrupção percebida, está representada no eixo horizontal em escala inversa, i.e. os países mais corruptos estão à esquerda.

Ao cimo, do lado direito, temos o cluster nórdico. A taxação é pesada, os cidadãos pagam com responsabilidade um Estado que consideram poder controlar democraticamente. Do lado inverso está o México, onde fugir aos impostos é uma virtude, já que o Estado emprega mal, supostamente sujeito a interesses particulares, os impostos que consegue "extorquir" aos cidadãos menos avisados. Curiosamente, o case-study, qual aberração, deveria ser a Suiça - sem se fazer pagar por isso de forma exagerada, a Administração consegue seguir razoáveis padrões éticos!

O que eu temo, na estratégia de sair da crise "por cima", é uma situação idêntica à que descrevi há duas semanas, na comparação dos rankings PISA e FIFA. No futebol, Portugal está a deixar o grupo dos latinos e a nivelar-se pelos nórdicos. Infelizmente, o mesmo não acontece nas competências científicas adquiridas no ensino, onde continuamos bem latinos. Na fiscalidade, existe ambição para chegarmos aos patamares nórdicos, mas no combate à corrupção, sendo muito difícil chegar ao nível da Itália, estamos de olhos postos na Hungria e na Rép. Checa.

Ouvido hoje na Comissão de Orçamento e Finanças, o Governador do Banco de Portugal disse que a «consolidação estrutural» das finanças públicas tanto pode ocorrer com elevada fiscalidade (deu o exemplo da Dinamarca) como com uma fiscalidade mais reduzida (deu o exemplo da Irlanda). Foi esta prelecção do sr. Governador ao deputado Frasquilho que me sugeriu a inclusão no gráfico de outra variável, para demonstrar que o "modelo dinamarquês", mesmo sem TGV, só funciona num determinado contexto cultural que não abrange os países latinos nem as antigas "repúblicas democráticas". Essa variável, corrupção percebida, está representada no eixo horizontal em escala inversa, i.e. os países mais corruptos estão à esquerda.

|

Ao cimo, do lado direito, temos o cluster nórdico. A taxação é pesada, os cidadãos pagam com responsabilidade um Estado que consideram poder controlar democraticamente. Do lado inverso está o México, onde fugir aos impostos é uma virtude, já que o Estado emprega mal, supostamente sujeito a interesses particulares, os impostos que consegue "extorquir" aos cidadãos menos avisados. Curiosamente, o case-study, qual aberração, deveria ser a Suiça - sem se fazer pagar por isso de forma exagerada, a Administração consegue seguir razoáveis padrões éticos!

O que eu temo, na estratégia de sair da crise "por cima", é uma situação idêntica à que descrevi há duas semanas, na comparação dos rankings PISA e FIFA. No futebol, Portugal está a deixar o grupo dos latinos e a nivelar-se pelos nórdicos. Infelizmente, o mesmo não acontece nas competências científicas adquiridas no ensino, onde continuamos bem latinos. Na fiscalidade, existe ambição para chegarmos aos patamares nórdicos, mas no combate à corrupção, sendo muito difícil chegar ao nível da Itália, estamos de olhos postos na Hungria e na Rép. Checa.

09/07/2009

Maioria absoluta?

Na tag Ai os media tenho revelado artigos jornalísticos, nomeadamente com origem na Lusa, que aceitam press releases sobre divulgação de "estudos", frequentemente apresentados como de cariz científico, cujas conclusões são mal fundamentadas em números ou estatísticas. Aos interessados, sugiro a leitura de posts onde declaro como falsos os seguintes títulos:

Três em cada quatro portugueses estão ligados à net

Portugal tem taxas de acesso à Internet superiores à média da União Europeia

Hoje apresento uma situação diferente, mas com génese na mesma facilidade com que a Lusa reencaminha as conclusões dos "estudos" promovidos por qualquer organização. Que falta faz um Gary Langer :)

O Público faz o título Maioria dos juízes não confia no programa informático CITIUS, explicitando depois que «Um estudo da Associação Sindical dos Juízes Portugueses (ASJP) sobre a utilização do CITIUS revela que 60 por cento dos juízes não confia na fiabilidade e segurança do programa» e que «O inquérito, de resposta anónima, foi enviado aos juízes em Maio e Junho, tendo sido consideradas 132 respostas, que representam 13,3 por cento do universo dos magistrados que neste momento trabalham obrigatoriamente com o CITIUS».

O título do Público é válido se se verificarem algumas condições. Se foi seleccionada uma amostra aleatória de 132 juízes do universo de 993 utilizadores do CITIUS. Se os 60% se reportam a uma base de 132. Nesse caso, podemos calcular o intervalo de confiança do estimador da resposta. Tendo em conta a taxa de sondagem (relevante neste caso, porque o universo é um pequeno domínio), para o típico nível de confiança de 95%, a margem de erro seria aprox. 8%, pelo que poderíamos dizer que a percentagem de juízes que "não confiam" se situa entre 52% e 68%.

E se aquelas condições não se verificarem? A minha resposta varia de acordo com a situação. Se o inquérito "foi enviado" aos 993 utilizadores e só responderam 132, o melhor é mandar o "estudo" para a reciclagem. Se "foi enviado" a uma amostra aleatória de n > 132, depende do rácio n/132. Se este valor for grande, seria necessário admitir que a "verdadeira" resposta não difere entre os que responderam e os que não responderam, o que é um pressuposto um bocado violento!

Finalmente, seria necessário ver como foi formulada a questão. O texto diz «não confia na fiabilidade e segurança», ou seja, apresenta a mesma resposta para dois conceitos diferentes. Se houve apenas uma pergunta para ambos os conceitos, é um mau indício.

Gary Langer não daria luz verde à publicação da notícia sem conhecer o questionário e as tabulações absolutas. Eu penso que um bom jornalista não faria aquele título sem se assegurar da qualidade do "estudo". O i optou por uma versão mais 'garantista': Estudo indica que maioria dos juízes não confia no programa informático CITIUS. Melhor teria sido incluir a referência ao promotor do estudo, colocando «da ASJP» entre "Estudo" e "indica", julgo eu, que não sou jornalista.

Três em cada quatro portugueses estão ligados à net

Portugal tem taxas de acesso à Internet superiores à média da União Europeia

Hoje apresento uma situação diferente, mas com génese na mesma facilidade com que a Lusa reencaminha as conclusões dos "estudos" promovidos por qualquer organização. Que falta faz um Gary Langer :)

O Público faz o título Maioria dos juízes não confia no programa informático CITIUS, explicitando depois que «Um estudo da Associação Sindical dos Juízes Portugueses (ASJP) sobre a utilização do CITIUS revela que 60 por cento dos juízes não confia na fiabilidade e segurança do programa» e que «O inquérito, de resposta anónima, foi enviado aos juízes em Maio e Junho, tendo sido consideradas 132 respostas, que representam 13,3 por cento do universo dos magistrados que neste momento trabalham obrigatoriamente com o CITIUS».

O título do Público é válido se se verificarem algumas condições. Se foi seleccionada uma amostra aleatória de 132 juízes do universo de 993 utilizadores do CITIUS. Se os 60% se reportam a uma base de 132. Nesse caso, podemos calcular o intervalo de confiança do estimador da resposta. Tendo em conta a taxa de sondagem (relevante neste caso, porque o universo é um pequeno domínio), para o típico nível de confiança de 95%, a margem de erro seria aprox. 8%, pelo que poderíamos dizer que a percentagem de juízes que "não confiam" se situa entre 52% e 68%.

E se aquelas condições não se verificarem? A minha resposta varia de acordo com a situação. Se o inquérito "foi enviado" aos 993 utilizadores e só responderam 132, o melhor é mandar o "estudo" para a reciclagem. Se "foi enviado" a uma amostra aleatória de n > 132, depende do rácio n/132. Se este valor for grande, seria necessário admitir que a "verdadeira" resposta não difere entre os que responderam e os que não responderam, o que é um pressuposto um bocado violento!

Finalmente, seria necessário ver como foi formulada a questão. O texto diz «não confia na fiabilidade e segurança», ou seja, apresenta a mesma resposta para dois conceitos diferentes. Se houve apenas uma pergunta para ambos os conceitos, é um mau indício.

Gary Langer não daria luz verde à publicação da notícia sem conhecer o questionário e as tabulações absolutas. Eu penso que um bom jornalista não faria aquele título sem se assegurar da qualidade do "estudo". O i optou por uma versão mais 'garantista': Estudo indica que maioria dos juízes não confia no programa informático CITIUS. Melhor teria sido incluir a referência ao promotor do estudo, colocando «da ASJP» entre "Estudo" e "indica", julgo eu, que não sou jornalista.

08/07/2009

(in)Sónias & alucinações

Já escrevi, num post de Maio, que Sócrates se identifica com os portugueses em geral, que «são os que dormem pior por causa da crise». Sócrates não dorme a pensar no (seu?) desemprego.

Na semana passada, o ex-ministro dos cornos, no dia da corrida, revelou-se bastante magoado por não ser devidamente reconhecido pelas suas insónias. Para as documentar, revelou-nos algumas das consequentes alucinações: «se nada se fizer até ao fim do século a temperatura média do planeta aumenta seis graus»; «os nossos bisnetos vão ter de emigrar para outro planeta». Pinho não dormia para «safar» postos de trabalho.

Sócrates e Pinho estão completamente enganados. Vê-se agora que não é com insónia que se «safa» postos de trabalho. Foi a Sónia que safou o do Governador do Banco de Portugal. A dormir nas sessões da comissão de inquérito, enquanto os seus colegas trabalhavam pela noite dentro.

Na semana passada, o ex-ministro dos cornos, no dia da corrida, revelou-se bastante magoado por não ser devidamente reconhecido pelas suas insónias. Para as documentar, revelou-nos algumas das consequentes alucinações: «se nada se fizer até ao fim do século a temperatura média do planeta aumenta seis graus»; «os nossos bisnetos vão ter de emigrar para outro planeta». Pinho não dormia para «safar» postos de trabalho.

Sócrates e Pinho estão completamente enganados. Vê-se agora que não é com insónia que se «safa» postos de trabalho. Foi a Sónia que safou o do Governador do Banco de Portugal. A dormir nas sessões da comissão de inquérito, enquanto os seus colegas trabalhavam pela noite dentro.

06/07/2009

Diana Mantra Vs Diana Chaves

Faz três semanas que cunhei o termo «efeito Diana Mantra» para designar o cálculo da margem de erro e/ou do intervalo de confiança de uma resposta com base num número de 'respondentes' superior ao que realmente respondeu.

A origem da designação do efeito foi uma troca de comentários com um internauta que assinava com aquelepseudónimo heterónimo neste post. No entanto, o verdadeiro 'pai' do efeito é o bloguista Carlos Santos, já que foi ele que, neste post, calculou de forma errada as margens de erro para as estimativas pontuais da intenção de voto no PS e no PSD, a partir dos resultados publicados de uma sondagem. O facto de o bloguista se apresentar como Doutor em Economia e professor universitário de Economia confere-lhe uma credibilidade relativa a conhecimentos de estatística, a qual poderá ter contribuído para que o referido post tenha sido citado por outros para opinar sobre algo tomado como certo, mas que, afinal, estava errado.

Depois de ter sito instado a esclarecer o efeito (neste comentário), resolvi fazê-lo agora, com recurso a gráficos, na expectativa de que a sua ilustração o torne mais compreensível.

Depois de ter sito instado a esclarecer o efeito (neste comentário), resolvi fazê-lo agora, com recurso a gráficos, na expectativa de que a sua ilustração o torne mais compreensível.

Vou apresentar um exemplo fictício, mas fundado na taxa de não-opinião que deveria ter sido apresentada pelas boas sondagens de intenção de voto nas últimas eleições para o Parlamento Europeu.

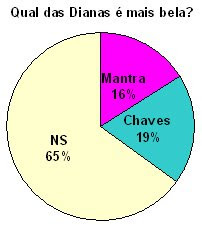

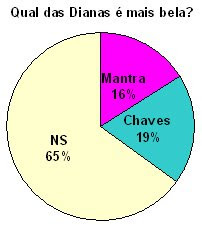

Admitamos que foi feita uma sondagem numa amostra de 1000 portugueses, para saber qual das Dianas é mais bela. A resposta (gráfico ao lado) revela uma preferência por Diana Chaves (mais 30 'votos' do que Diana Mantra), mas o dado mais saliente é que quase 2/3 dos inquiridos não revelam opinião, seja porque não sabem qual das duas é mais bonita, qual das duas é mais feia, quem raio será a Diana Mantra... ou, simplesmente, estão-se nas tintas para a pergunta.

Podemos, a partir dos resultados desta 'sondagem', dizer que os portugueses consideram Chaves mais bela do que Mantra? Obviamente, a resposta é não, porque há uma 'maioria qualificada' de portugueses que não se pronuncia. Agora, admitamos que a pergunta não é sobre quem é a mais bela, mas sobre em quem votará num concurso de beleza (e que as respostas são as mesmas). Isto é, vai haver uma eleição e ganha quem tiver mais votos, independentemente de quantos portugueses votarem. Podemos, a partir dos resultados desta 'sondagem', dizer, com 'alguma segurança', que a Chaves é mais votada do que a Mantra?

A resposta consiste na avaliação do seguinte problema: a diferença de três pontos percentuais na amostra é suficientemente grande para se admitir como muito provável que a intenção de voto seja favorável a Chaves na população? Se a amostra for probabilística e se a sondagem cumprir as "boas práticas", poderemos calcular uma margem de erro para a diferença entre Chaves e Mantra e ver se a diferença obtida na amostra é "suficientemente grande", i.e. maior do que a margem de erro. É o que farei mais à frente, considerando que a amostra é aleatória. Antes, irei ilustrar no gráfico abaixo as margens de erro para as estimativas pontuais separadas de Chaves e Mantra, que foi a abordagem utilizada por Carlos Santos.

Os resultados de Chaves estão representados a azul e os de Mantra a rosa. Ao fundo, do lado esquerdo, temos os intervalos de estimação a partir dos resultados brutos. À estimativa pontual soma-se / subtrai-se a margem, que é obtida por 1,96*RAIZQ((p*(1-p)/(n-1))), sendo p a proporção de 'votos' e n o tamanho da amostra. Com p=0,16 e p=o,19, para Mantra e Chaves, respectivamente, e com n=1000, os intervalos de estimação sobrepõem-se, como é visível no gráfico, já que o ponto superior do intervalo de Mantra (18,3%) é maior do que o ponto inferior do intervalo de Chaves (16,6%).

O «efeito Diana Mantra» está assinalado pela seta. Considerando o método de cálculo de Carlos Santos, as proporções de 'votos' são calculadas a partir da amostra de inquiridos com opinião (no=350), mas as margens de erro são calculadas como se toda a amostra tivesse emitido opinião (n=1000). Se n for apenas ligeiramente superior a no, não há problemas de maior com esta forma de cálculo errónea. No entanto, em situações de elevada 'abstenção', como é o caso, utilizar 1000 'respondentes' para avaliar o erro de medida de 350 respostas, é uma barbaridade. Com este "passe de magia", os intervalos de estimação deixariam de estar sobrepostos e Diana Chaves teria razões para estar muito mais contente com estes "resultados" do que Vital Moreira com os resultados das sondagens de Maio.

O «efeito Diana Mantra» está assinalado pela seta. Considerando o método de cálculo de Carlos Santos, as proporções de 'votos' são calculadas a partir da amostra de inquiridos com opinião (no=350), mas as margens de erro são calculadas como se toda a amostra tivesse emitido opinião (n=1000). Se n for apenas ligeiramente superior a no, não há problemas de maior com esta forma de cálculo errónea. No entanto, em situações de elevada 'abstenção', como é o caso, utilizar 1000 'respondentes' para avaliar o erro de medida de 350 respostas, é uma barbaridade. Com este "passe de magia", os intervalos de estimação deixariam de estar sobrepostos e Diana Chaves teria razões para estar muito mais contente com estes "resultados" do que Vital Moreira com os resultados das sondagens de Maio.

Na parte superior do gráfico estão os intervalos de estimação dos 'votos' considerando os 'votantes' reais, i.e. n=no=350. As estimativas pontuais são as mesmas, mas as margens de erro são muito superiores, mantendo-se a sobreposição dos, agora larguíssimos, intervalos: Mantra poderia obter entre 40,5% e 50,9%, enquanto Chaves poderia ter entre 49,1% e 59,5%. Estamos em presença dos "intervalos de confiança" de 10% de que se queixava (?) Jorge de Sá.

Para finalizar, apresento o cálculo da margem de erro que é a adequada ao problema, i.e. a margem de erro da diferença entre duas categorias de resposta. Calculando 1,96*RAIZQ((((pM+pC)-(pM-pC)^2))/(n-1)), em que pM representa a proporção de Mantra e pC a proporção de Chaves, pode-se dizer que a diferença entre pC e pM (3%) na resposta à pergunta sobre qual delas é mais bela, é inferior à margem de erro dessa diferença (3,7%), calculada com n=1000. Portanto, no típico nível de confiança de 95%, não se pode garantir que a Chaves seja mais bela.

Também a diferença de 'intenções de voto' nas duas beldades ("esticada" para 8,6% quando se considera apenas respondentes com opinião), é inferior à respectiva margem de erro, calculada com n=350 (10,5%). Portanto, no típico nível de confiança de 95%, não se pode garantir que a população portuguesa tenha maior intenção de votar em Diana Chaves do que em Diana Mantra.

A origem da designação do efeito foi uma troca de comentários com um internauta que assinava com aquele

Depois de ter sito instado a esclarecer o efeito (neste comentário), resolvi fazê-lo agora, com recurso a gráficos, na expectativa de que a sua ilustração o torne mais compreensível.

Depois de ter sito instado a esclarecer o efeito (neste comentário), resolvi fazê-lo agora, com recurso a gráficos, na expectativa de que a sua ilustração o torne mais compreensível.Vou apresentar um exemplo fictício, mas fundado na taxa de não-opinião que deveria ter sido apresentada pelas boas sondagens de intenção de voto nas últimas eleições para o Parlamento Europeu.

Admitamos que foi feita uma sondagem numa amostra de 1000 portugueses, para saber qual das Dianas é mais bela. A resposta (gráfico ao lado) revela uma preferência por Diana Chaves (mais 30 'votos' do que Diana Mantra), mas o dado mais saliente é que quase 2/3 dos inquiridos não revelam opinião, seja porque não sabem qual das duas é mais bonita, qual das duas é mais feia, quem raio será a Diana Mantra... ou, simplesmente, estão-se nas tintas para a pergunta.

Podemos, a partir dos resultados desta 'sondagem', dizer que os portugueses consideram Chaves mais bela do que Mantra? Obviamente, a resposta é não, porque há uma 'maioria qualificada' de portugueses que não se pronuncia. Agora, admitamos que a pergunta não é sobre quem é a mais bela, mas sobre em quem votará num concurso de beleza (e que as respostas são as mesmas). Isto é, vai haver uma eleição e ganha quem tiver mais votos, independentemente de quantos portugueses votarem. Podemos, a partir dos resultados desta 'sondagem', dizer, com 'alguma segurança', que a Chaves é mais votada do que a Mantra?

A resposta consiste na avaliação do seguinte problema: a diferença de três pontos percentuais na amostra é suficientemente grande para se admitir como muito provável que a intenção de voto seja favorável a Chaves na população? Se a amostra for probabilística e se a sondagem cumprir as "boas práticas", poderemos calcular uma margem de erro para a diferença entre Chaves e Mantra e ver se a diferença obtida na amostra é "suficientemente grande", i.e. maior do que a margem de erro. É o que farei mais à frente, considerando que a amostra é aleatória. Antes, irei ilustrar no gráfico abaixo as margens de erro para as estimativas pontuais separadas de Chaves e Mantra, que foi a abordagem utilizada por Carlos Santos.

Os resultados de Chaves estão representados a azul e os de Mantra a rosa. Ao fundo, do lado esquerdo, temos os intervalos de estimação a partir dos resultados brutos. À estimativa pontual soma-se / subtrai-se a margem, que é obtida por 1,96*RAIZQ((p*(1-p)/(n-1))), sendo p a proporção de 'votos' e n o tamanho da amostra. Com p=0,16 e p=o,19, para Mantra e Chaves, respectivamente, e com n=1000, os intervalos de estimação sobrepõem-se, como é visível no gráfico, já que o ponto superior do intervalo de Mantra (18,3%) é maior do que o ponto inferior do intervalo de Chaves (16,6%).

O «efeito Diana Mantra» está assinalado pela seta. Considerando o método de cálculo de Carlos Santos, as proporções de 'votos' são calculadas a partir da amostra de inquiridos com opinião (no=350), mas as margens de erro são calculadas como se toda a amostra tivesse emitido opinião (n=1000). Se n for apenas ligeiramente superior a no, não há problemas de maior com esta forma de cálculo errónea. No entanto, em situações de elevada 'abstenção', como é o caso, utilizar 1000 'respondentes' para avaliar o erro de medida de 350 respostas, é uma barbaridade. Com este "passe de magia", os intervalos de estimação deixariam de estar sobrepostos e Diana Chaves teria razões para estar muito mais contente com estes "resultados" do que Vital Moreira com os resultados das sondagens de Maio.

O «efeito Diana Mantra» está assinalado pela seta. Considerando o método de cálculo de Carlos Santos, as proporções de 'votos' são calculadas a partir da amostra de inquiridos com opinião (no=350), mas as margens de erro são calculadas como se toda a amostra tivesse emitido opinião (n=1000). Se n for apenas ligeiramente superior a no, não há problemas de maior com esta forma de cálculo errónea. No entanto, em situações de elevada 'abstenção', como é o caso, utilizar 1000 'respondentes' para avaliar o erro de medida de 350 respostas, é uma barbaridade. Com este "passe de magia", os intervalos de estimação deixariam de estar sobrepostos e Diana Chaves teria razões para estar muito mais contente com estes "resultados" do que Vital Moreira com os resultados das sondagens de Maio.Na parte superior do gráfico estão os intervalos de estimação dos 'votos' considerando os 'votantes' reais, i.e. n=no=350. As estimativas pontuais são as mesmas, mas as margens de erro são muito superiores, mantendo-se a sobreposição dos, agora larguíssimos, intervalos: Mantra poderia obter entre 40,5% e 50,9%, enquanto Chaves poderia ter entre 49,1% e 59,5%. Estamos em presença dos "intervalos de confiança" de 10% de que se queixava (?) Jorge de Sá.

Para finalizar, apresento o cálculo da margem de erro que é a adequada ao problema, i.e. a margem de erro da diferença entre duas categorias de resposta. Calculando 1,96*RAIZQ((((pM+pC)-(pM-pC)^2))/(n-1)), em que pM representa a proporção de Mantra e pC a proporção de Chaves, pode-se dizer que a diferença entre pC e pM (3%) na resposta à pergunta sobre qual delas é mais bela, é inferior à margem de erro dessa diferença (3,7%), calculada com n=1000. Portanto, no típico nível de confiança de 95%, não se pode garantir que a Chaves seja mais bela.

Também a diferença de 'intenções de voto' nas duas beldades ("esticada" para 8,6% quando se considera apenas respondentes com opinião), é inferior à respectiva margem de erro, calculada com n=350 (10,5%). Portanto, no típico nível de confiança de 95%, não se pode garantir que a população portuguesa tenha maior intenção de votar em Diana Chaves do que em Diana Mantra.

04/07/2009

Sócrates segundo as sondagens

Segundo o líder parlamentar do BE, as as sondagens “estão no banco dos réus da opinião pública”. Já escrevi bastante sobre este assunto aqui no blogue, os leitores que chegam pela primeira vez poderão ler dois posts recentes sobre duas atitudes diferentes face ao problema: 1) um comunicado da ERC a varrer o lixo para debaixo do tapete; 2) aquilo a que chamei glasnost da Marktest.

Hoje resolvi escrever sobre a abissal diferença de resultados entre duas sondagens publicadas esta semana. Se a indústria não souber esclarecer a opinião pública e, particularmente, a opinião publicada sobre esta diferença, então é fácil concluir que é muito curta a distância entre o banco dos réus e o cadafalso.

Falo da diferença relativa à avaliação daquilo que os órgãos de comunicação social costumam designar "popularidade" dos líderes políticos. Há uma pergunta sobre a actuação, neste caso, do Primeiro Ministro, os inquiridos podem avaliá-la de forma positiva ou negativa e os media costumam calcular a diferença, construindo um índice de popularidade. Eu não vou analisar este índice, mas apenas as respostas "Positiva" e "Negativa", nas sondagens da Marktest (resultados aqui) e da Eurosondagem (resultados aqui).

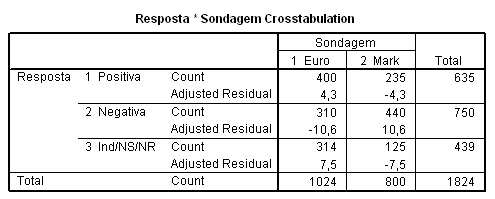

O quadro seguinte apresenta os resultados. No caso da Marktest são as tabulações reais, no caso da Eurosondagem são imputadas de acordo com os resultados divulgados pelo Expresso. A Marktest utilizou a pergunta «Em sua opinião diria que a actuação do 1º Ministro e actual líder do PS - JOSÉ SÓCRATES, tem sido POSITIVA ou NEGATIVA?». Desconhecemos a pergunta da Eurosondagem, mas vê-se que o Expresso apresenta uma categoria de resposta, "Nem boa, nem má", não prevista no questionário da Marktest. Neste primeiro quadro, esta categoria de resposta foi adicionada aos inquiridos que não manifestaram opinião.

Além da frequência das respostas (linha Count), o quadro apresenta os desvios ajustados, i.e. uma medida de desvio de cada célula relativamente à hipótese segundo a qual os resultados de ambas sondagens são idênticos. Com o habitual intervalo de confiança de 95%, um valor de desvio ajustado superior a +/- 2 indica que o desvio é significativo. É fácil constatar que a opinião dos inquiridos Marktest é incomparavelmente muito mais negativa e que a Eurosondagem apresenta resultados de "indecisos" superiores (o que é natural, dado que acrescentámos a categoria de resposta da imagem nem boa nem má), mas também de imagem positiva consideravelmente superior.

A estatística (qui-quadrado) diz-nos que é 2 triliões de vezes mais provável acertar no Euromilhões do que estas sondagens estarem a medir o mesmo conceito (opinião sobre actuação de Sócrates) na mesma população (eleitores residentes no continente em lares com telefone fixo).

Admitindo que a diferença se pudesse dever ao facto de haver uma categoria adicional de resposta no questionário da Eurosondagem, vamos, por absurdo, transferir todas as respostas "Nem boa, nem má" para a categoria "Negativa" e comparar os resultados, da mesma forma. A Marktest continua a apresentar maior proporção de resposta "Negativa", embora o desvio não seja significativo. Naturalmente, a sobrerrepresentação da resposta "Positiva" na Eurosondagem mantém-se. Os desvios seriam menores neste caso, mas, ainda assim, a probabilidade de se tratar da mesma medida na mesma população é de 1 sobre 6 milhões.

Perante o mesmo problema, as duas sondagens apresentam, pelo menos na divulgação pública, duas respostas antagónicas. Segundo os resultados da Marktest, os eleitores portugueses fazem uma avaliação negativa da actuação de Sócrates. Segundo os resultados da Eurosondagem, há mais portugueses a considerar essa actuação positiva do que negativa. Pelo menos uma das medidas está errada. Atendendo ao que se ouve e se lê por aí, é muito provável que seja a da Eurosondagem.

Nota: não é de excluir que o método de selecção dos inquiridos também possa afectar a medida. A Marktest usa o método de quotas e a Eurosondagem um método supostamente probabilístico. No entanto, o principal factor deve ser a formulação da pergunta e as alternativas de resposta. Infelizmente, não conheço o questionário da Eurosondagem, mas é de louvar a iniciativa da Marktest de ter divulgado o questionário e as tabulações.

Hoje resolvi escrever sobre a abissal diferença de resultados entre duas sondagens publicadas esta semana. Se a indústria não souber esclarecer a opinião pública e, particularmente, a opinião publicada sobre esta diferença, então é fácil concluir que é muito curta a distância entre o banco dos réus e o cadafalso.

Falo da diferença relativa à avaliação daquilo que os órgãos de comunicação social costumam designar "popularidade" dos líderes políticos. Há uma pergunta sobre a actuação, neste caso, do Primeiro Ministro, os inquiridos podem avaliá-la de forma positiva ou negativa e os media costumam calcular a diferença, construindo um índice de popularidade. Eu não vou analisar este índice, mas apenas as respostas "Positiva" e "Negativa", nas sondagens da Marktest (resultados aqui) e da Eurosondagem (resultados aqui).

O quadro seguinte apresenta os resultados. No caso da Marktest são as tabulações reais, no caso da Eurosondagem são imputadas de acordo com os resultados divulgados pelo Expresso. A Marktest utilizou a pergunta «Em sua opinião diria que a actuação do 1º Ministro e actual líder do PS - JOSÉ SÓCRATES, tem sido POSITIVA ou NEGATIVA?». Desconhecemos a pergunta da Eurosondagem, mas vê-se que o Expresso apresenta uma categoria de resposta, "Nem boa, nem má", não prevista no questionário da Marktest. Neste primeiro quadro, esta categoria de resposta foi adicionada aos inquiridos que não manifestaram opinião.

Além da frequência das respostas (linha Count), o quadro apresenta os desvios ajustados, i.e. uma medida de desvio de cada célula relativamente à hipótese segundo a qual os resultados de ambas sondagens são idênticos. Com o habitual intervalo de confiança de 95%, um valor de desvio ajustado superior a +/- 2 indica que o desvio é significativo. É fácil constatar que a opinião dos inquiridos Marktest é incomparavelmente muito mais negativa e que a Eurosondagem apresenta resultados de "indecisos" superiores (o que é natural, dado que acrescentámos a categoria de resposta da imagem nem boa nem má), mas também de imagem positiva consideravelmente superior.

A estatística (qui-quadrado) diz-nos que é 2 triliões de vezes mais provável acertar no Euromilhões do que estas sondagens estarem a medir o mesmo conceito (opinião sobre actuação de Sócrates) na mesma população (eleitores residentes no continente em lares com telefone fixo).

|

Admitindo que a diferença se pudesse dever ao facto de haver uma categoria adicional de resposta no questionário da Eurosondagem, vamos, por absurdo, transferir todas as respostas "Nem boa, nem má" para a categoria "Negativa" e comparar os resultados, da mesma forma. A Marktest continua a apresentar maior proporção de resposta "Negativa", embora o desvio não seja significativo. Naturalmente, a sobrerrepresentação da resposta "Positiva" na Eurosondagem mantém-se. Os desvios seriam menores neste caso, mas, ainda assim, a probabilidade de se tratar da mesma medida na mesma população é de 1 sobre 6 milhões.

|

Perante o mesmo problema, as duas sondagens apresentam, pelo menos na divulgação pública, duas respostas antagónicas. Segundo os resultados da Marktest, os eleitores portugueses fazem uma avaliação negativa da actuação de Sócrates. Segundo os resultados da Eurosondagem, há mais portugueses a considerar essa actuação positiva do que negativa. Pelo menos uma das medidas está errada. Atendendo ao que se ouve e se lê por aí, é muito provável que seja a da Eurosondagem.

Nota: não é de excluir que o método de selecção dos inquiridos também possa afectar a medida. A Marktest usa o método de quotas e a Eurosondagem um método supostamente probabilístico. No entanto, o principal factor deve ser a formulação da pergunta e as alternativas de resposta. Infelizmente, não conheço o questionário da Eurosondagem, mas é de louvar a iniciativa da Marktest de ter divulgado o questionário e as tabulações.

02/07/2009

A ciência do futebol

Neste post, Micas10 defende que é preciso pôr "bandeiras nas janelas" para fazer Portugal subir nos rankings PISA. A escrita de Micas10 levou-me a construir o gráfico abaixo, relacionando a posição dos países da OCDE nos testes PISA relativos a ciências com a ordem que ocupa(va)m na lista global da FIFA em 2006 (data do rank PISA) e em 2009.

Há um grupo de países (Coreia, Finlândia, Canadá e N. Zelândia) que são bons na educação científica, mas jogam mal à bola - quem é que quer isso???

Há outro grupo de países, a que Portugal pertencia por direito, juntamente com Espanha e Itália, onde os "miúdos" exercitam melhor os pés do que a cabeça. Os Estados Unidos estão a fazer o possível para intregar este grupo, ao contrário de Portugal, que se está a esforçar por sair.

Há dois grandes professores empenhados neste desígnio nacional. O Prof. Queiroz está cumprindo a sua parte, conseguindo com sucesso fugir a Espanha e Itália. Agora só falta o Prof. Rui Santos transmitir as suas capacidades científicas aos jovens, e poderemos ombrear com novos adversários 'naturais', como Suécia, Dinamarca e Suiça, contra os quais temos tido "azar"... só o Prof. Rui Santos poderá evitar a mexicanizaçãodo nosso futebol da nossa ciência!

Há um grupo de países (Coreia, Finlândia, Canadá e N. Zelândia) que são bons na educação científica, mas jogam mal à bola - quem é que quer isso???

Há outro grupo de países, a que Portugal pertencia por direito, juntamente com Espanha e Itália, onde os "miúdos" exercitam melhor os pés do que a cabeça. Os Estados Unidos estão a fazer o possível para intregar este grupo, ao contrário de Portugal, que se está a esforçar por sair.

Há dois grandes professores empenhados neste desígnio nacional. O Prof. Queiroz está cumprindo a sua parte, conseguindo com sucesso fugir a Espanha e Itália. Agora só falta o Prof. Rui Santos transmitir as suas capacidades científicas aos jovens, e poderemos ombrear com novos adversários 'naturais', como Suécia, Dinamarca e Suiça, contra os quais temos tido "azar"... só o Prof. Rui Santos poderá evitar a mexicanização

|

Um problema de credibilidade

Um comentário neste post diz o essencial: «Empresas que estudam a opinião pública não percebem que têm uma má imagem na opinião pública?»

É tempo de quem está no back office (estudos de mercado) salte para o front office, recorrendo a uma política de comunicação que informe os eleitores sobre o que são sondagens, como se fazem, como se interpretam e como são utilizadas por quem as compra. Ter alguém com grande visibilidade mediática a comentar sondagens da mesma forma que comenta(va) os penalties contra o Sporting não ajuda mesmo nada...

Perante uma decisão tão estúpida como proibir a sua divulgação, a "opinião pública" está a reagir mais contra as sondagens do que contra os censores! Por outro lado, como diz António Salvador, «Quanto mais criticarem as sondagens, mais subvalorizadas estas serão e menos os eleitores responderão de forma séria e fidedigna». A glasnost de que falei no post anterior deveria servir para elucidar os políticos, jornalistas e comentadores, mas não tem impacto no público, a não ser por intermédio dos líderes de opinião.

É tempo de quem está no back office (estudos de mercado) salte para o front office, recorrendo a uma política de comunicação que informe os eleitores sobre o que são sondagens, como se fazem, como se interpretam e como são utilizadas por quem as compra. Ter alguém com grande visibilidade mediática a comentar sondagens da mesma forma que comenta(va) os penalties contra o Sporting não ajuda mesmo nada...

Perante uma decisão tão estúpida como proibir a sua divulgação, a "opinião pública" está a reagir mais contra as sondagens do que contra os censores! Por outro lado, como diz António Salvador, «Quanto mais criticarem as sondagens, mais subvalorizadas estas serão e menos os eleitores responderão de forma séria e fidedigna». A glasnost de que falei no post anterior deveria servir para elucidar os políticos, jornalistas e comentadores, mas não tem impacto no público, a não ser por intermédio dos líderes de opinião.

01/07/2009

Novidades nas fichas técnicas

A divulgação de duas sondagens eleitorais recentes trouxe novidades - pelo menos no que respeita à ficha técnica!

A sondagem do CESOP que "dá" uma esmagadora vitória a Rui Rio, foi divulgada na comunicação social com uma inovação nas margens de erro: em vez de uma margem única que corresponderia ao total da amostra, diz-se que «as margens de erro máximas estão situadas entre 3,7 e 4,2 por cento, com um nível de confiança de 95 por cento». Num post de 15 de Junho, eu salientava que «a informação da ficha técnica que os media publicam por obrigação legal é enganadora». Esta abordagem do CESOP é um progresso, ao apresentar uma margem de erro para o total da amostra (3,7) e outra para a parte da amostra que revelou intenção de voto (4,2). No entanto, como já por várias vezes o escrevi, não são estas as margens de erro que verdadeiramente interessam!

Já a divulgação do barómetro de Junho da Marktest, que inclui uma sondagem sobre intenção de voto nas legislativas, inaugura uma glasnost na indústria das sondagens! Para contrariar o problema de difícil interpretação jornalística das sondagens, a ficha técnica do barómetro insta os órgãos de comunicação a remeter os leitores para o site da Marktest e os jornalistas a lerem a ficha detalhata, disponibilizando o contacto de email de um técnico para esclarecer dúvidas. Aplausos para a iniciativa! Sem ter consultado Bárbara Gomes, deixo aqui a minha visão sobre o que de mais interessante achei nesta ficha técnica detalhada.

Em primeiro lugar, a divulgação do número de contactos estabelecidos e a ventilação de quantas entrevistas foram feitas à kª tentativa. É muito importante verificar que foram chamados 21560 números de telefone para obter 800 entrevistas válidas. Foi para esta realidade que procurei chamar a atenção dos leitores no meu primeiro post sobre sondagens e, sobretudo, para a forma como ela não é reflectida nas fichas técnicas.

Em segundo lugar, um indicador de qualidade é a insistência no número de tentativas para obter a entrevista. A sondagem demorou cinco dias porque houve um esforço para conseguir entrevistar o elemento do lar seleccionado. Tal não é possível quando se fazem sondagens de dois dias, como eu disse aqui, criticando particularmente o CESOP por ter realizado uma sondagem em apenas dois dias, no fim-de-semana do 25 de Abril, mas pensando também nas sondagens telefónicas da Eurosondagem. Note-se que esta "obrigação" de "esperar" pelo elemento seleccionado nem sequer é determinante no método de quotas, utilizado pela Marktest, é-o muito mais no caso dos concorrentes que utilizam uma selecção (dita) aleatória.

Em terceiro lugar, a divulgação das perguntas utilizadas. Algo que teria sido muito últil para compreender as discrepâncias entre os valores de "abstencionistas" apresentados por diferentes sondagens para as eleições europeias.

Em quarto lugar, a apresentação do "erro estatístico máximo" de cada ventilação. Neste caso, o ideal seria apresentar os erros das percentagens obtidas, em vez dos erros máximos para as sub-populações.

Em quinto lugar, a disponibilização das tabulações. Infelizmente, não foi apresentada para a intenção de voto nas legislativas, mas apenas para as habituais perguntas do barómetro (ou está nalgum sítio que não atingi?) Com estes dados e um conhecimento básico de estatística, é possível calcular intervalos de confiança, margens de erro, diferenças entre respostas, entre sub-populações, etc.

Finalmente, uma exposição clara do método de projecção de voto nas legislativas, apresentando, para além da projecção, as percentagens brutas e as percentagens relativas dentro dos respondentes que manifestaram intenção de voto. Sabe-se, assim, que dos 800 inquiridos, apenas 452 revelaram intenção de voto - uma informação muito importante para a Diana Mantra ;)

A sondagem do CESOP que "dá" uma esmagadora vitória a Rui Rio, foi divulgada na comunicação social com uma inovação nas margens de erro: em vez de uma margem única que corresponderia ao total da amostra, diz-se que «as margens de erro máximas estão situadas entre 3,7 e 4,2 por cento, com um nível de confiança de 95 por cento». Num post de 15 de Junho, eu salientava que «a informação da ficha técnica que os media publicam por obrigação legal é enganadora». Esta abordagem do CESOP é um progresso, ao apresentar uma margem de erro para o total da amostra (3,7) e outra para a parte da amostra que revelou intenção de voto (4,2). No entanto, como já por várias vezes o escrevi, não são estas as margens de erro que verdadeiramente interessam!

Já a divulgação do barómetro de Junho da Marktest, que inclui uma sondagem sobre intenção de voto nas legislativas, inaugura uma glasnost na indústria das sondagens! Para contrariar o problema de difícil interpretação jornalística das sondagens, a ficha técnica do barómetro insta os órgãos de comunicação a remeter os leitores para o site da Marktest e os jornalistas a lerem a ficha detalhata, disponibilizando o contacto de email de um técnico para esclarecer dúvidas. Aplausos para a iniciativa! Sem ter consultado Bárbara Gomes, deixo aqui a minha visão sobre o que de mais interessante achei nesta ficha técnica detalhada.

Em primeiro lugar, a divulgação do número de contactos estabelecidos e a ventilação de quantas entrevistas foram feitas à kª tentativa. É muito importante verificar que foram chamados 21560 números de telefone para obter 800 entrevistas válidas. Foi para esta realidade que procurei chamar a atenção dos leitores no meu primeiro post sobre sondagens e, sobretudo, para a forma como ela não é reflectida nas fichas técnicas.

Em segundo lugar, um indicador de qualidade é a insistência no número de tentativas para obter a entrevista. A sondagem demorou cinco dias porque houve um esforço para conseguir entrevistar o elemento do lar seleccionado. Tal não é possível quando se fazem sondagens de dois dias, como eu disse aqui, criticando particularmente o CESOP por ter realizado uma sondagem em apenas dois dias, no fim-de-semana do 25 de Abril, mas pensando também nas sondagens telefónicas da Eurosondagem. Note-se que esta "obrigação" de "esperar" pelo elemento seleccionado nem sequer é determinante no método de quotas, utilizado pela Marktest, é-o muito mais no caso dos concorrentes que utilizam uma selecção (dita) aleatória.

Em terceiro lugar, a divulgação das perguntas utilizadas. Algo que teria sido muito últil para compreender as discrepâncias entre os valores de "abstencionistas" apresentados por diferentes sondagens para as eleições europeias.

Em quarto lugar, a apresentação do "erro estatístico máximo" de cada ventilação. Neste caso, o ideal seria apresentar os erros das percentagens obtidas, em vez dos erros máximos para as sub-populações.

Em quinto lugar, a disponibilização das tabulações. Infelizmente, não foi apresentada para a intenção de voto nas legislativas, mas apenas para as habituais perguntas do barómetro (ou está nalgum sítio que não atingi?) Com estes dados e um conhecimento básico de estatística, é possível calcular intervalos de confiança, margens de erro, diferenças entre respostas, entre sub-populações, etc.

Finalmente, uma exposição clara do método de projecção de voto nas legislativas, apresentando, para além da projecção, as percentagens brutas e as percentagens relativas dentro dos respondentes que manifestaram intenção de voto. Sabe-se, assim, que dos 800 inquiridos, apenas 452 revelaram intenção de voto - uma informação muito importante para a Diana Mantra ;)

Subscrever:

Mensagens (Atom)